· 13 min read

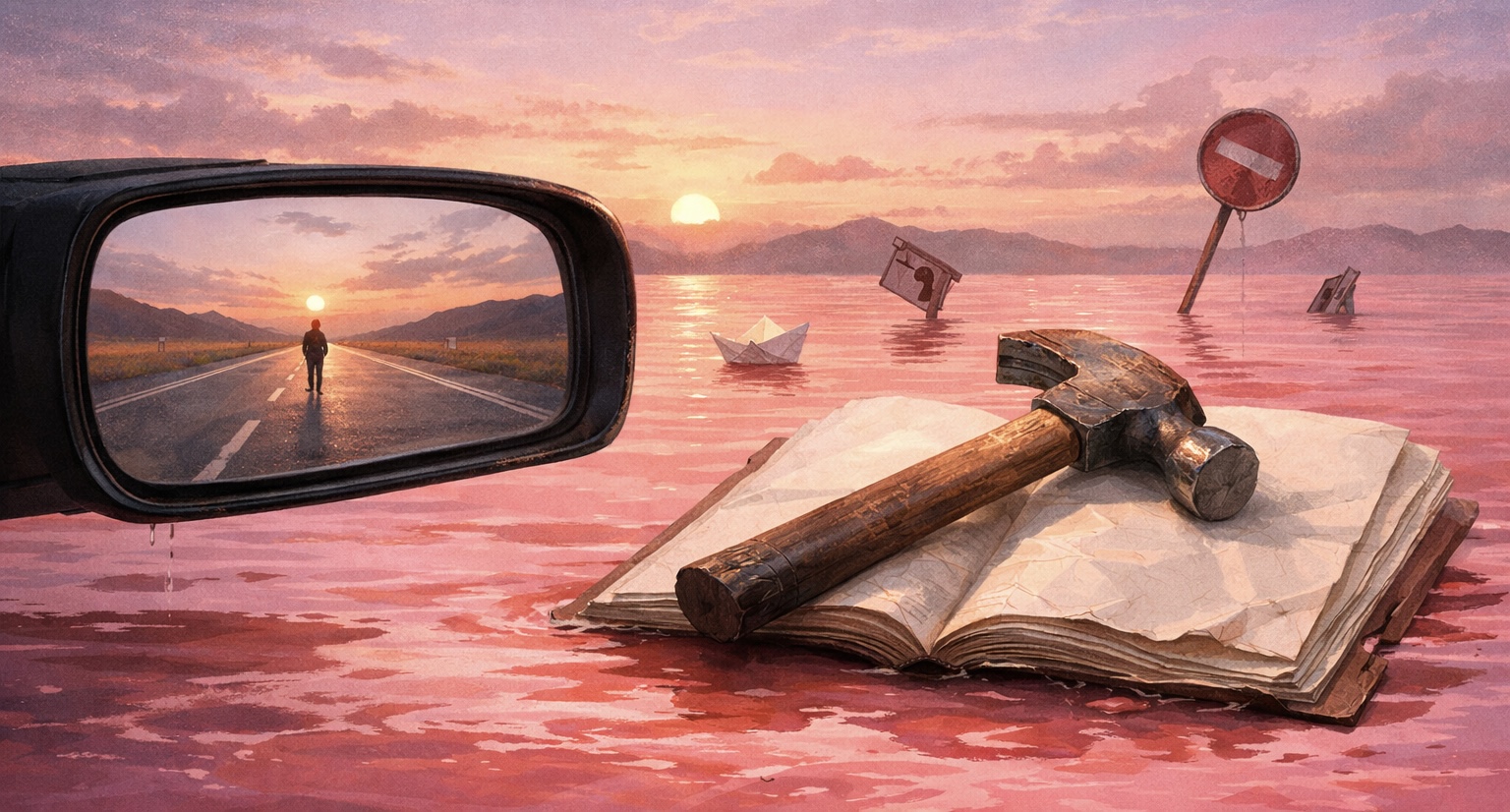

后视镜、粉红色的水和没有说明书的锤子

未来难以预测,因为它总是伪装成过去的样子。

在使用Notion、obsidian、hepatabase这些知识管理工具时,我也一直关心**它们的创始人如何理解「思考」本身。**Notion创始人Ivan Zhao前几天在x上发表了一篇文章《Steam, Steel, and Infinite Minds》,提出一个命题:我们需要重新想象知识工作者的未来。

未来难以预测,因为它总是伪装成过去的样子。他提到知识工作者要想拥有真正的“思维汽车”,必须先解决两个根本问题:

- 上下文碎片化(Context Fragmentation)

- 可验证性(Verifiability)

我尝试梳理一下我的理解和启发。

上下文碎片化:为什么AI 还是不够聪明?

Ivan提到的第一个问题是上下文碎片化。

在代码的世界里,环境是高度提纯的。工具和上下文通常存在于一个地方:IDE、代码库、终端。AI 可以读取完整上下文,直接生成、修改、测试代码、最终生成完美代码。

但知识工作者,生活在一个碎片化的黑洞中。

我们需要吞吐的信息分散在各种工具和场景中:微信对话、网页、邮件、PPT、文档、会议、即时想法、线下交流……AI 无法接触完整上下文,只能处理一些局部、窄化的任务。现在我们还是在用人脑这种高能耗的生物计算机,在不同工具来回切换、复制、粘贴、提纯来手动整合信息。

即使我们投喂大量资料训练、更新迭代提示词,也无法做到完全整合,无法像编程 AI 那样端到端完成复杂工作。只要信息依然碎片化,AI 就无法真正介入我们的工作流。

可验证性:反馈回路是否完整?

第二个问题可验证性怎么理解呢?

AlphaGo 能通过几百万局自我对弈变强,因为它知道输赢。代码能通过报错信息验证对错,本身就是一种明确的反馈系统。模型制作者利用这一点来训练 AI 提升编程能力。

但知识工作者的产出就不可验证,处于一种“薛定谔的绩效”之中。

一个项目是否管理得当?一份新品上市传播策略效果好不好?这个政策真的可行吗? …这些问题的反馈通常是滞后的、模糊的,甚至不可归因的。即便结果不错,我们也未必知道是否源于那一次决策。在这样的环境下,AI 很难通过强化学习不断变强,它不可能靠写一百万份周报进化,因为没有满分的标准。

所以即使在 AI 时代,定义“什么是好”的权力,依然掌握在人类手中。

这两个问题让我继续思考我们在当下应如何更好地使用知识工具。我又看了两个月前Ivan跟计算机先驱、图灵奖得主 Alan Kay(艾伦·凯)之间的一场线上对话:《How to Build Tools That Shape Civilizations》。他们没有谈论Notion本身,而是更偏向于人类、工具和文明的哲学探讨。Alan Kay引用了麦克卢汉的一些观点,有三个很有意思的隐喻:

- 后视镜视角

马歇尔·麦克卢汉说“人类是通过后视镜驶向未来的。”意思是说人们总是用旧有的思维框架和经验去理解新事物,就像开车时只看后视镜,用过去的景象来应对前方未知的道路。

Ivan 在他的文章中也提到,当前我们对 AI 的使用也只是让它辅助人类现有的工作流程, 我们还没有学会在高速公路开汽车,还在蹬自行车。

Alan举例电视的诞生,人们最初只是用电视播放广播节目,或把电影搬进客厅。但电视最终创造的是一整套全新的文化逻辑:真人秀、冲突、戏剧性被正常化。他直言不讳:我们现在的政治生态、甚至总统的诞生,本质上都是电视、互联网这些媒介重新塑造人类行为标准的结果。这种认知错位导致我们经常误判新技术的真正规模和破坏力。工具塑造我们的方式,并不是强迫我们做什么,而是悄无声息改变了我们对正常的定义。

- 粉红色的水

麦克卢汉还有一个经典隐喻,用来解释为什么我们很难察觉技术带来的改变。一条只待在粉色水里的鱼,根本不会有‘粉色’这个概念。

这就是我们目前的处境。 社交媒体的算法流、高度流程化的协作系统等等,它们共同构成了我们的认知环境。**当一个环境持续奖励短平快、情绪化、即时反馈,深度思考就会自然萎缩。**最明显的变化是:我们甚至连社交媒体的评论都懒得写了,只剩下点赞。

所以我们需要保持对「水」的觉知,刻意跳出鱼缸,寻找「蓝色想法」:那些来自艺术、历史或科学的异质视角。

- 危险的锤子

如果环境是隐形的,那工具就是危险的诱饵。Ivan 问工具是否能帮助人类克服认知盲点?Alan 引用了 Xerox PARC 先驱 Doug Engelbart 的警告:

人类的天性决定了我们无法通过单纯使用锤子来学会如何合理地使用锤子。

因为我们本质上是实用主义者,我们只想从 A 点到达 B 点,我们不关心 C 点。所以他说:“每当我们制造像电脑这样的新工具时,我们必须在人类和工具之间插入教育和培训,否则我们将制造出信息时代的氢弹。”但当 80 年代商业化浪潮来袭时,这个理念被抛到了九霄云外。那时的基本理念变成了:只要我们能卖出去的就是好东西,我们不会去训练或是教育任何人。

今天,工具越来越强,信息越来越多,我们感到更疲惫、更混乱。AI 让答案唾手可得,但如果思维结构没有升级,越强大的工具,只会让我们在错误的道路上跑得越快。

因为商业化社会只负责把锤子卖给我们,不负责教我们如何成为建筑师。工具可以帮我们一键生成,但不会教我们怎样辨别真伪、构建逻辑或利用它进行深度思考。

在商业化抛弃了教育责任的时候,那我们更要完成自我教育。在AI可以代替人类做很多事、甚至思考的时候,人类更加要注重思考本身。

真正的增强,必须发生在人这一端。

人类如何增强?

使用工具,应该像学习一件乐器。 它难以上手,需要长期训练,但一旦掌握就能真正扩展人的能力边界。Alan说的一句话我印象很深刻:

如果你不让自己产生想法,就很难有想法。尽可能保持更多的想法,并跟它们保持距离。

这里有两点理解:

1. 我们需要生产自己的想法而不是只消费别人的想法。因为发现问题,比解决问题更重要。现代教育和企业过度沉迷于解决问题,但真正推动文明飞跃、复杂项目进展的是往往不是更快的解法,而是全新的视角。

2. 不要过度坚持或者过早批判自己的想法。大脑里应该有一个“疯狂室”用来产生狂野的想法,和一个“理智室”用来执行。过早的评判,会扼杀真正有潜力的思想。过于坚持自己的想法,又容易走向封闭。所以,对于想法也好、信息也好,都要保持距离。

回到工具端,我们能怎么运用工具?

回看 Ivan 提出的两个问题:第一个问题相对容易。Notion、obsidian、Heptabase等工具正是在试图解决上下文碎片化的问题。我们也可以为自己构建一个统一的平台,承载个人的上下文。第二个问题,仍然开放。但至少可以确定一件事:我们必须守住自己的思考能力。

我们也只能从当下出发,去想象和建构一个能让自己持续思考的系统。如果我们的输入和学习只是在堆积笔记、剪藏有价值的文章内容,那样所谓的“第二大脑”只是一个信息仓库;只有当这个系统能辅助你产生新连接、验证假设、拓展逻辑时,它才是一个思考系统。

我们需要给自己的原则是:

- 存入高价值上下文

放弃一键剪藏,只保留经过判断、真正重要的内容。有意识把知识内化、工作经验SOP沉淀下来,进行结构化梳理。未来AI可以更进一步协助,我们的笔记思考就不再只是给自己看的,更是给我们的 AI Co-pilot 看的。

- 从资料管理员到思考学习者

放弃记录xxx书、xx课学习笔记,转为具有颗粒度的记录。经过思考后的信息拆解为足够细的原子化笔记,才能让自己好用,让AI好用。

- 保留记录阻力强迫思考

不为了方便性牺牲深度。强迫自己去写Prompt,去定义问题、制定标准。让AI成为思维伙伴,而不是生成答案的机器:让它反驳我、帮我发现盲点、整理碎片、拓展视角。

以上就是我目前,能给出的最现实的理解和回应。欢迎交流探讨呀~